前腳謝賽寧剛宣告VAE在圖像生成領域退役,后腳清華與快手可靈團隊也帶著無VAE潛在擴散模型SVG來了。

該方法實現了在訓練效率上62倍、生成速度上35倍的提升。

VAE為何被接連拋棄?主要還是因為語義糾纏的缺陷——語義特征都放在同一個潛空間,調一個數值就會“牽一發而動全身”,比如只想改變貓的顏色,結果體型、表情都跟著變。

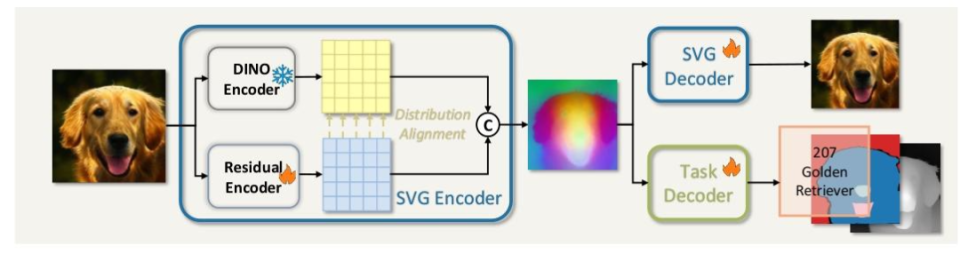

和謝賽寧團隊極簡復用預訓練編碼器、改造DiT架構,專注于生成性能的RAE不同,SVG通過語義+細節雙分支+分布對齊,實現了多任務通用。

下面具體來看。

主動構建語義與細節融合的特征空間

在傳統的「VAE+擴散模型」圖像生成范式中,VAE的核心作用是將高分辨率圖像壓縮為低維的潛空間特征(可以理解為圖像的簡化代碼),供后續擴散模型學習生成邏輯。

但這樣會使不同類別、不同語義的圖像特征會混亂地交織在一起,比如貓和狗的特征邊界模糊不清等。

直接導致兩個問題:

-

一是擴散模型訓練效率極低,需要數百萬步迭代才能勉強理清特征邏輯;

-

二是生成過程繁瑣,往往需要經過幾十甚至上百步采樣才能輸出清晰圖像。

并且,生成的特征空間用途單一,除了圖像生成,幾乎無法適配圖像識別、語義分割等其他視覺任務。

面對VAE的困境,謝賽寧團隊的RAE技術選擇了極致聚焦生成的思路。直接復用DINOv2、MAE等成熟的預訓練編碼器,不額外修改編碼器結構,僅通過優化解碼器來還原圖像細節,同時針對性地改造擴散模型架構。

最終實現了生成效率與質量的跨越式提升,簡單說就是把重心全放在了“把圖生成得又快又好”上。

而清華&快手可靈團隊的SVG技術,則走了兼顧生成與多任務通用的路線,核心差異就在于對特征空間的構建邏輯上。

RAE是直接復用預訓練特征,SVG 則是主動構建語義與細節融合的特征空間。