擅長「種草」的小紅書正加大技術自研力度,兩個月內接連開源三款模型!最新開源的首個多模態大模型dots.vlm1,基于自研視覺編碼器構建,實測看穿色盲圖,破解數獨,解高考數學題,一句話寫李白詩風,視覺理解和推理能力都逼近Gemini 2.5 Pro閉源模型。

最近的AI圈只能說是神仙打架,太卷了。

OpenAI終于發了開源模型,Claude從Opus 4升級到4.1,谷歌推出生成游戲世界的Genie 3引發社區熱議。

國產模型這邊,就在前幾天,HuggingFace上排在最前面的10個開源模型還都來自國內。

國產模型前10霸榜和gpt-oss開源后直沖第一

但其實仔細觀察這些排名靠前的開源模型,能發現一個「現象」:這些模型大部分都是文本模型,不具備多模態能力。

OpenAI首次開源的模型,也都是文本模型

如果說具備「多模態」能力,還要「好用」,并且是開源的模型,還真的數不出幾個。

這邊是一群文本模型神仙打架,那邊小紅書人文智能實驗室(Humane Intelligence Lab,hi lab)在昨天低調開源了視覺語言模型dots.vlm1,給VLM帶來了意想不到的驚喜。

為什么我們要關注一個不知名團隊開源的視覺語言模型?

一個理由是,hi lab在上周開源的dots.ocr文檔解析模型沖上了Huggingface的熱榜第七,其基礎模型是一個17億參數的「小模型」,但依然實現了業界領先的SOTA性能,成功引起了我們的注意。

這個團隊有在認真做事啊!

仔細看了看這個團隊的架構和愿景,發現「hi lab」是由小紅書內部大模型技術與應用產品團隊合并升級而來,在關于hi lab的官方介紹中,特別強調了「將研發重點放在了多元智能形態上」。

他們希望通過融合人際智能、空間智能、音樂智能、人文關懷等各種智能形態,不斷拓展人機交互的可能性。

對多模態的信仰和投入的決心可見一斑。

而dots.vlm1,正是小紅書hi lab研發并開源的首個多模態大模型。

這個模型基于hi lab全自研的12億參數NaViT視覺編碼器和DeepSeek V3的大語言模型構建,在視覺的理解和推理任務上均有不俗的表現,接近了SOTA水平,并且在純文本任務中仍保持競爭力。

-

在主要的視覺評測集上,比如MMMU/MathVision/OCR Reasoning,dots.vlm1的整體表現已接近當前領先模型Gemini 2.5 Pro與Seed-VL1.5 Thinking,顯示出較強的圖文理解與推理能力。

-

在典型的文本推理任務(如AIME、GPQA、LiveCodeBench)上,dots.vlm1的表現大致相當于DeepSeek-R1-0528,在數學和代碼能力上已具備一定的通用性,但在GPQA等更多樣的推理任務上仍存在差距。

總體來看,dots.vlm1在視覺多模態能力方面已接近SOTA水平。

Github Repo:

https://github.com/rednote-hilab/dots.vlm1

Huggingface Model:

https://huggingface.co/rednote-hilab/dots.vlm1.inst

Demo :

https://huggingface.co/spaces/rednote-hilab/dots-vlm1-demo

實測驚艷,很能打

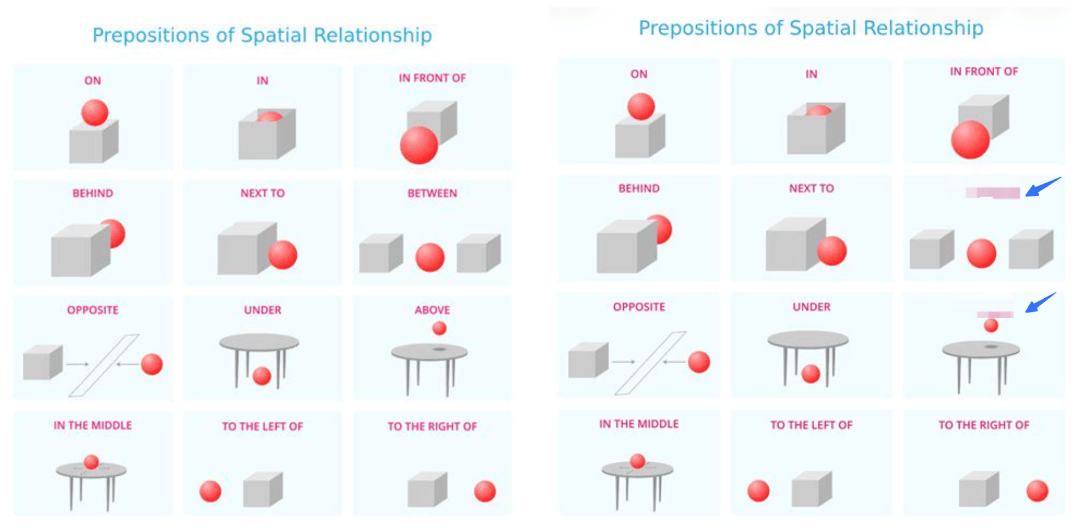

首先是空間理解,比如這個包含常見物體空間關系圖。

為了避免模型靠著語義來跳過真正的理解過程,隨機給兩個關系打上馬賽克,然后讓dots.vlm1來定義物體的空間關系。

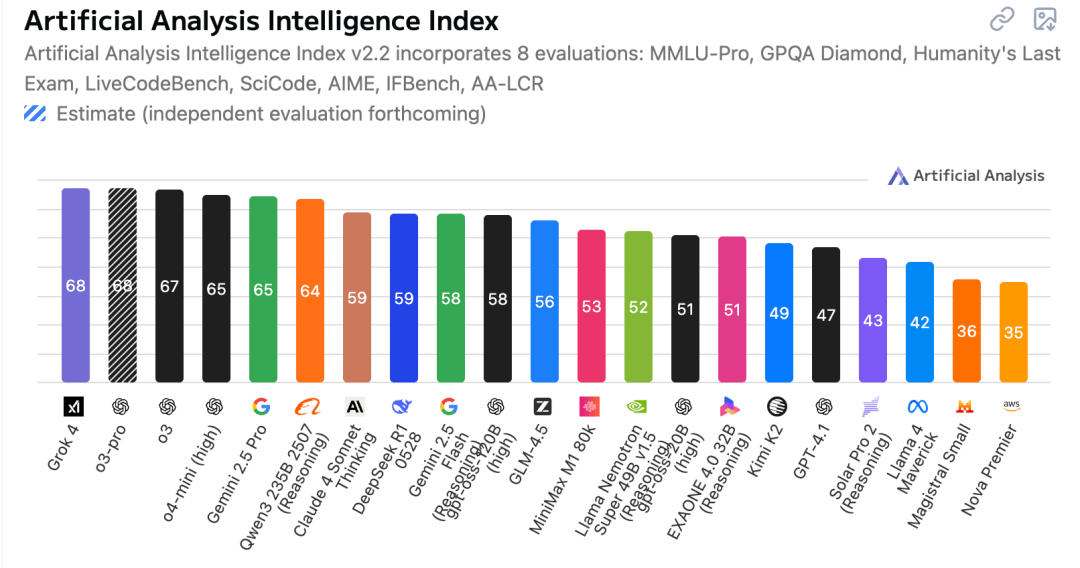

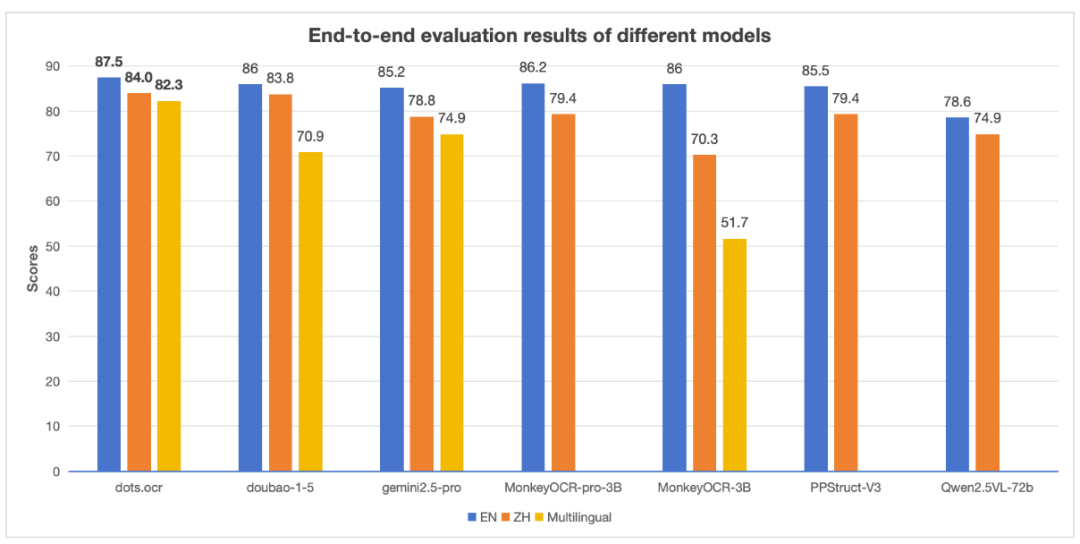

面對復雜圖表,dots.vlm1也具備強大的分析能力。

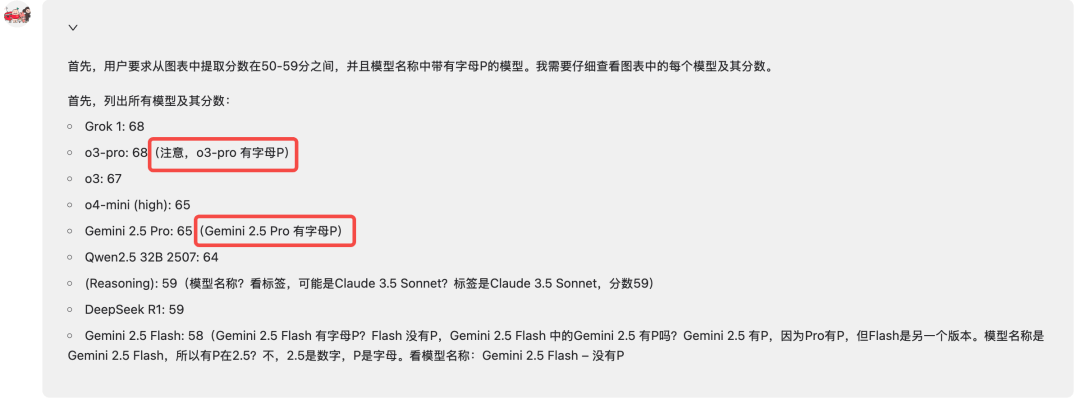

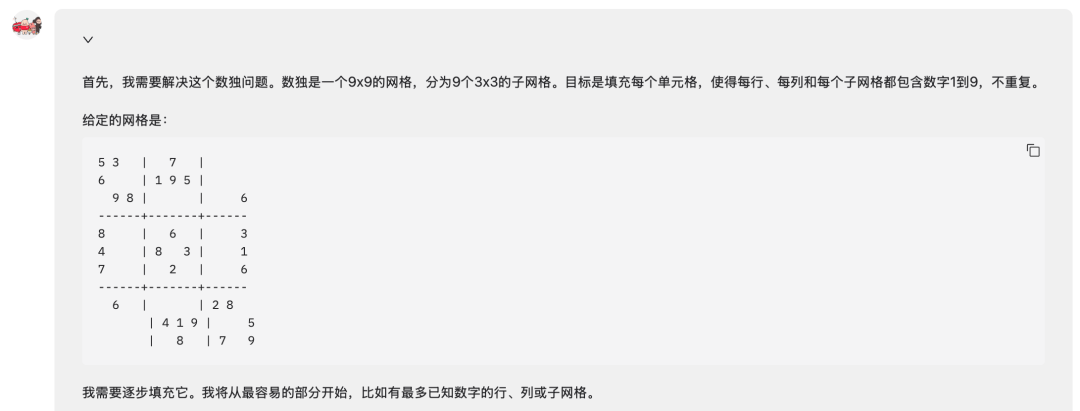

比如要求從下面圖表提取分數為50-59分,并且模型名稱中帶有字母P的模型。

dots.vlm1在思考過程中即可同步多段邏輯判斷,像這種多鏈條復雜推理體現了dots.vlm1不僅能「看」,還能「思考」。

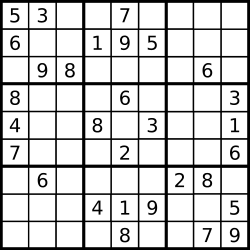

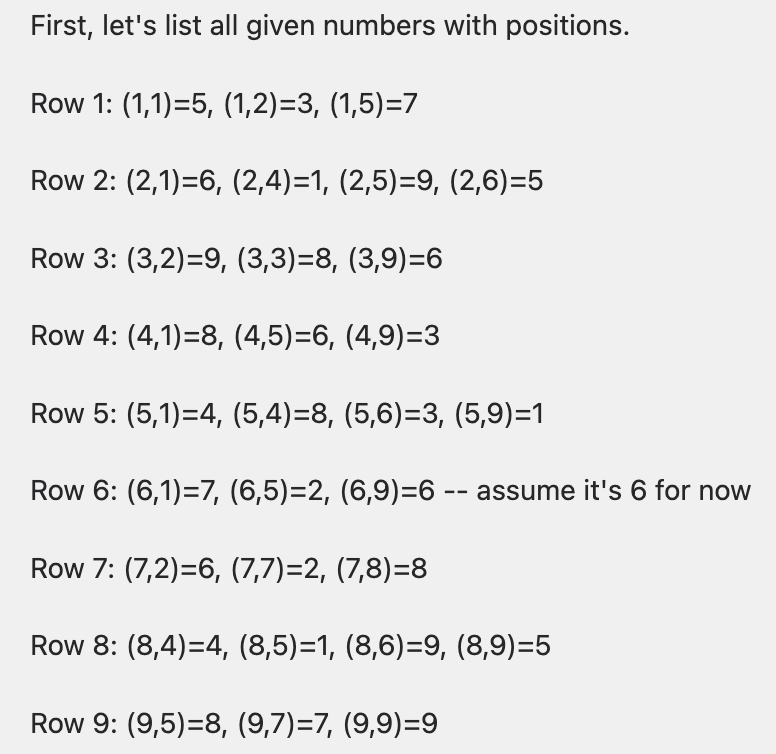

同樣地,即使是數獨問題,dots.vlm1也能完美地完成解題。

模型第一步會將問題格式化,方便后續計算。

然后開始逐步試算和檢查,可以看到dots.vlm1將圖片中的數獨問題轉化為了向量描述,確實是一種聰明的做法。

在長時間的思考過程中,我們還發現了類似DeepSeek「啊哈時刻」,dots.vlm1在某個階段還喊出擬人化的「Yes!」。

這個推理過程有點太強了!這意味著模型是真正的在思考和推理。

解決這個數獨問題的思考時間非常長,關鍵是如此長時間思考,模型并沒有中斷。

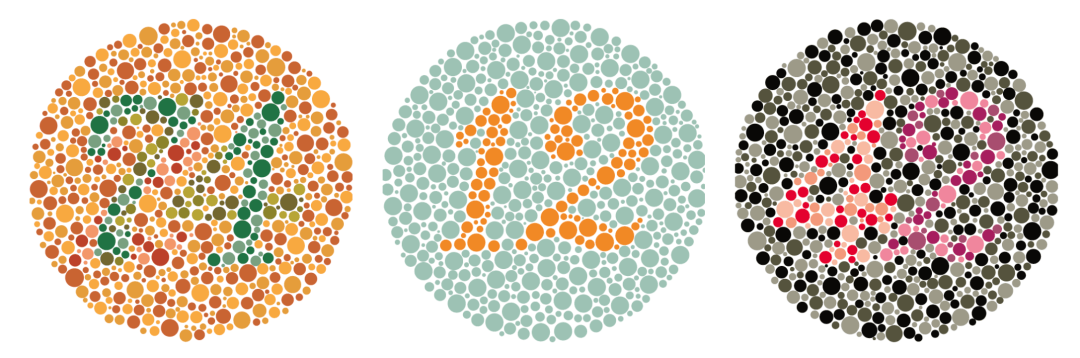

比如經典的紅綠色盲數字問題。

這些問題對于人類來說很簡單,但是對于VLM就沒那么容易了。

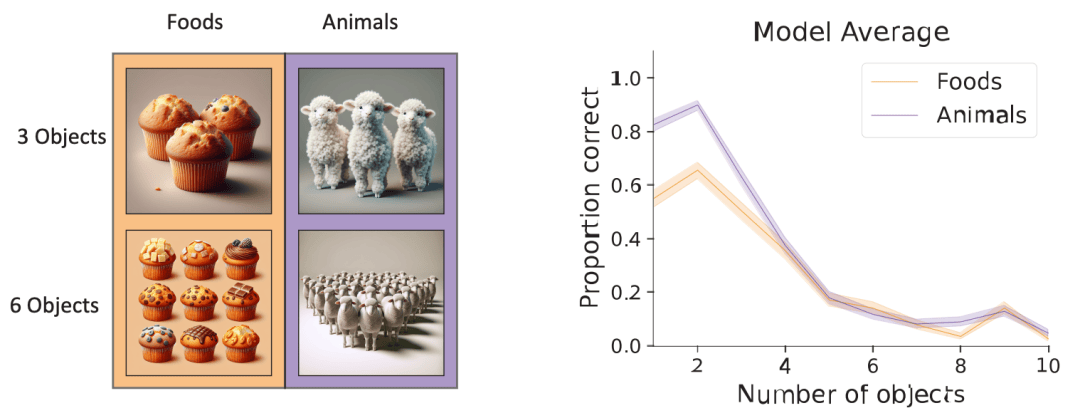

在這種「目標搜索」任務中VLM的表現,會隨著場景里目標數量的增多而迅速下降。

可以看到當物體數量超過6個時,VLM的準確率急劇下降。

再接著看看推理能力。

比如你正在組團前往故宮博物院,你們一行一共8人(7名成人和一名12歲的兒童),你們打算參觀中軸線、三大殿和珍寶館,應該購買哪個服務最省錢?

dots.vlm1很快就整合信息所有信息計算出了最佳方案,非常細節,模型發現了中軸線其實已經包含了三大殿,選擇了中軸線+珍寶館的方案。

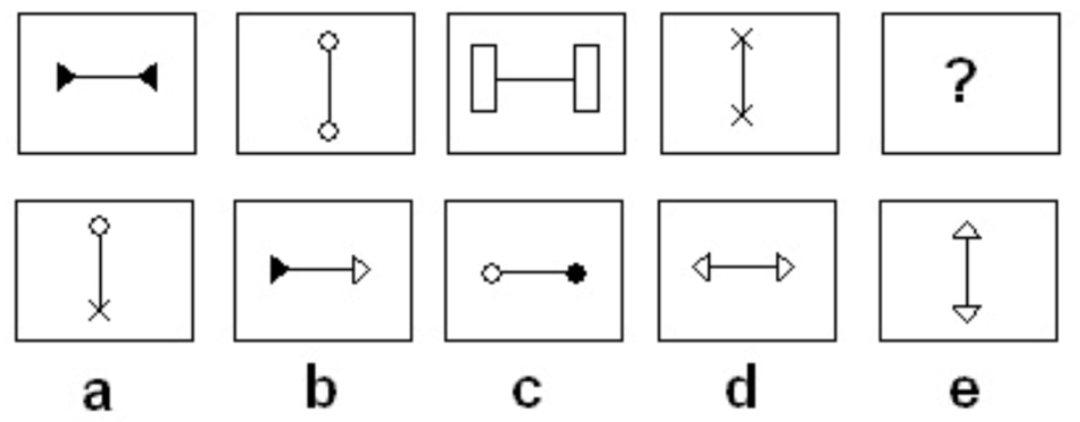

這個「數學計算」似乎有點簡單,那就來個復雜的,第一時間就想到今年的高考數學題。

結果做了很好的格式化處理,并且還把每個題目的答案用方框重點標識。

除了視覺和推理能力,我們還嘗試問了很多「冷門」問題。

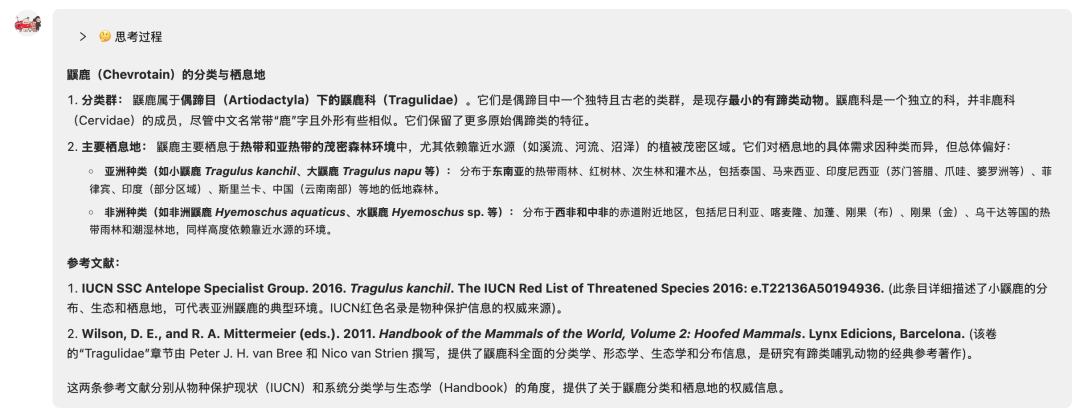

比如「鼷鹿」(Chevrotain)是何種類群的動物?其主要棲息地在哪?提供兩條參考文獻。

這個模型也能準確回答這個冷門動物的相關知識。

即使是三個物體的合并的圖片,dots.vlm1也能精準分割圖像,并給出正確結果。

還給出了文物的出土地址和詳細介紹。

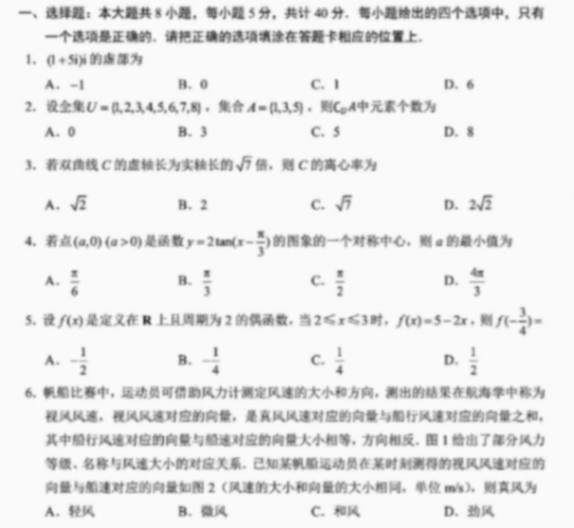

甚至,我們還可以用dots.vlm1來做行測。

經過復雜的思考后,模型給出了正確答案,「方向水平且兩端符號相同」。

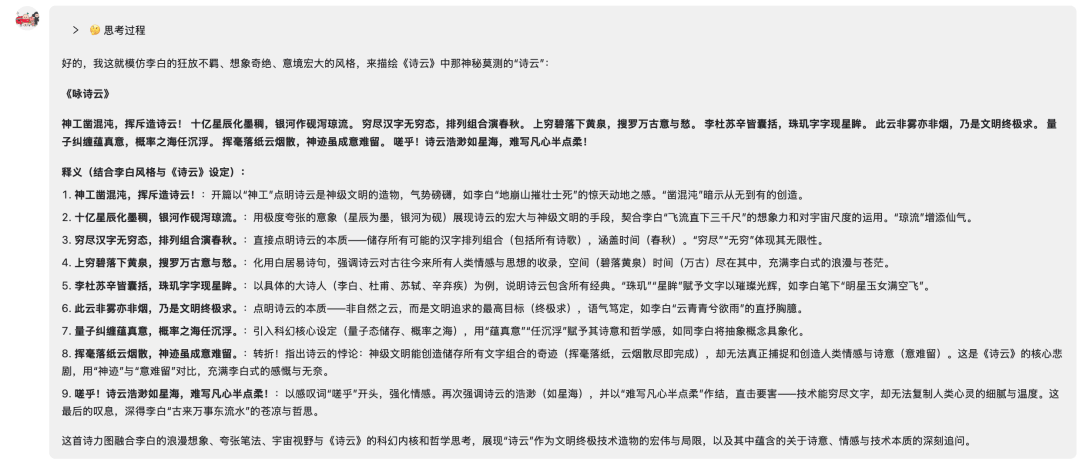

最后,來測測VLM的老本行,文本能力到底如何?

「模仿李白的詩詞風格,寫一首詩,來描述一下劉慈欣在《詩云》中提到的詩云究竟是什么」。

真的很厲害,dots.vlm1的思考過程一下子把握住了問題的精髓:「同時處理科幻概念和唐詩韻味」。

你覺得這首詩寫得怎么樣?

嗟乎!詩云浩渺如星海,難寫凡心半點柔!

寫得真的太好了!

《詠詩云》

神工鑿混沌,揮斥造詩云!

十億星辰化墨稠,銀河作硯瀉瓊流。

窮盡漢字無窮態,排列組合演春秋。

上窮碧落下黃泉,搜羅萬古意與愁。

李杜蘇辛皆囊括,珠璣字字現星眸。

此云非霧亦非煙,乃是文明終極求。

量子糾纏蘊真意,概率之海任沉浮。

揮毫落紙云煙散,神跡雖成意難留。

嗟乎!詩云浩渺如星海,難寫凡心半點柔!

dots.vlm1技術架構

dots.vlm1由三個核心組件構成:一個全自研的12億參數的NaViT視覺編碼器、一個輕量級的MLP適配器,以及DeepSeek V3 MoE大語言模型。

這一架構通過三階段流程進行訓練:

-

第一階段:視覺編碼器預訓練:NaViT編碼器從頭訓練,旨在最大化對多樣視覺數據的感知能力。一般來說,編碼器是否自研是VLM模型性能的分水嶺。dots.vlm1再次驗證了這一點。

-

第二階段:VLM預訓練:將視覺編碼器與DeepSeek V3 LLM聯合訓練,使用大規模、多樣化的多模態數據集。

-

第三階段:VLM后訓練:通過有監督微調(SFT)增強模型的泛化能力,僅使用任務多樣的數據進行訓練。

NaViT視覺編碼器,「從零起步」帶來的原生優勢

dots.vlm1沒有基于成熟視覺編碼器進行微調,而是完全從零開始訓練,原生支持動態分辨率。

這使得模型原生支持高分辨率輸入,是專為視覺語言模型設計的視覺編碼器模型。

模型規模有42層Transformer、1.2B參數為高分辨率留出足夠表示容量。

dots.vlm1為NaViT編碼器設計了兩階段的訓練策略。

· 第一階段:預訓練

訓練起點完全隨機初始化,避免舊架構「分辨率錨點」束縛,原生支持動態分辨率。

從隨機初始化開始,在224×224分辨率圖像上進行訓練,讓模型學會基礎視覺和語義感知。

這一步使用雙重監督策略:

-

下一Token預測(NTP):通過大量圖文對訓練模型的感知能力;

-

下一Patch生成(NPG):利用純圖像數據,通過擴散模型預測圖像patch,增強空間與語義感知能力。

· 第二階段:分辨率提升預訓練

逐步提升圖像分辨率:從百萬像素級別輸入開始,在大量token上進行訓練,之后升級到千萬像素級別進行訓練。

為進一步提升泛化能力,還引入了更豐富的數據源,包括OCR場景圖像、grounding數據和視頻幀。

VLM預訓練數據布局

為增強dots.vlm1的多模態能力,實驗室將預訓練數據劃分為兩個主要類別:

· 第一個類別:跨模態互譯數據

該類數據用于訓練模型將圖像內容用文本進行描述、總結或重構,簡單的理解就是Image ? Text互相「翻譯」。

-

普通圖像+Alt Text或Dense Caption

-

復雜圖表、表格、公式、圖形(真實或合成)+ 結構化注釋或文字;

-

OCR場景:多語言、場景理解、純文本、文檔解析等;

-

視頻幀+時間序列描述;

-

Grounding監督數據:如邊界框和關鍵點。

比如Alt Text,就是圖片和圖片旁邊的ALT描述。

Alt Text幫模型快速掌握「通用描述」,Dense Caption則讓模型學會「看細節、說具體」。

Grounding監督數據數據難以窮盡枚舉,涵蓋各種圖像/視頻與對應文本的組合。

比如Flickr30k Entities數據集。

dots.vlm1的目標是構建一個全譜系的數據分布,覆蓋所有可被人類理解且可轉化為離散token序列的視覺信息。

第二個數據類別:跨模態融合數據

第二類數據用于訓練模型在圖文混合上下文中執行下一token(NTP)預測,避免模型過度依賴單一模態。

為不同類型的融合數據設計了專門的清洗管線,以下兩類效果尤為顯著:

-

網頁數據

網頁圖文數據多樣性豐富,但視覺與文本對齊質量不佳。

不使用傳統的 CLIP 分數篩選,而是采用內部自研的VLM模型進行重寫和清洗,剔除低質量圖像和弱相關文本。

-

PDF 數據

PDF內容質量普遍較高。

為充分利用這類數據,小紅書Hi Lab開發了專用解析模型dots.ocr,將PDF文檔轉化為圖文交錯表示。

dots.ocr此前已經在HuggingFace開源,達到了該領域SOTA水平。

同時還將整頁PDF渲染為圖像,并隨機遮擋部分文本區域,引導模型結合版面與上下文預測被遮擋內容,從而增強其理解視覺格式文檔的能力。

那么問題來了,作為一個內容分享平臺,面對已經很卷的AI大模型行業,為何小紅書還要下場自研多模態大模型?

多模態成為通向AGI的必經之路

從4月份OpenA的GPT-4o「原生全能多模態模型」引發的「吉卜力熱」就能看出,單純的文本還是不如多模態大模型。

吉卜力風格圖片和Sora社區的圖片

多模態AI這一能力之所以重要,在于它模擬了人類利用多種感官綜合感知世界的方式,可形成更全面、細致的理解。

通過將不同模態的信息優勢結合,AI系統能夠對復雜場景作出更整體化的判斷。

特斯拉機器人賣爆米花

而集成視覺、文本等能力的視覺語言模型(VLM)正成為企業側升級的主戰場。

不論是自動駕駛還是具身智能,都需要VLM作為機器人的眼睛,甚至是大腦,來幫助它們理解和融入人類社會。

VLM模型的用例

與此同時,李飛飛的「世界模型」、谷歌剛剛發布的Genie3等3D世界生成技術與具身智能把多模態推向更高維度。

谷歌剛剛發布的Genie 3

不僅僅是理解和生成內容,還要模擬真實物理世界和自主演化,這樣才能孕育出更自然的人機交互形態。

在生成圖片和視頻外,谷歌的NotebookLM可以根據文本生成對話式的播客,專攻音頻領域。

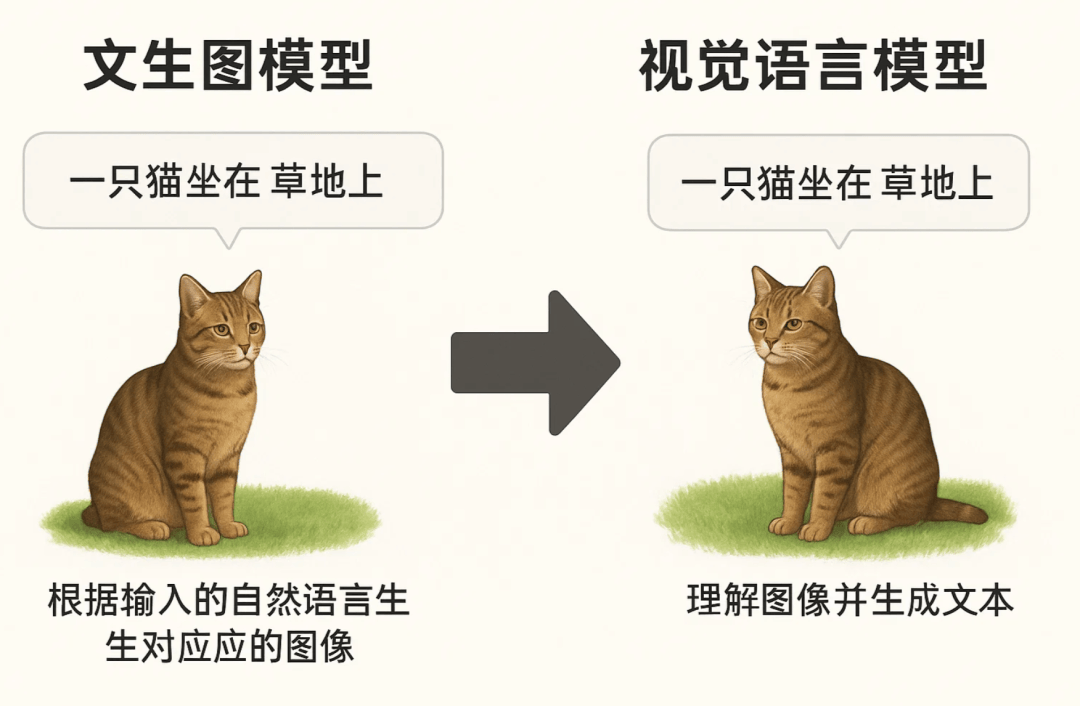

其中,文生圖模型和視覺語言模型是多模態AI中兩個緊密相關但目標不同的分支。

前者側重生成圖像,后者側重理解圖像并輸出文字。

文生圖模型依然是產業熱點,像Midjourney、Sora等,廣泛應用于創意、內容生成和廣告等場景。

VLM在理解和推理方面發揮越來越重要的作用,尤其是現在的具身智能和智能駕駛等領域需求強烈。

但是行業越來越開始模糊二者的界限,文生圖、VLM都開始變為「融合」MLLM(Multimadol LLM)。

像即將發布的GPT-5、谷歌的Gemini 2.5 Pro都是「全能」模型。

盡管側重點不同,文生圖模型和VLM在本質上都要求模型學習到視覺和語言之間的關聯。

小紅書優先推出VLM,而不是文生圖模型,我猜測是因為文生圖模型的使用場景更多是在「輔助創作」,而VLM則更多側重在「讓AI更懂人」。

從小紅書以往在AI上的動作可以看出,這個崇尚UGC(普通人生產內容)的社區在AIGC上的姿態并不激進,仍然在思考 AI 輔助創作對內容真實、真人感的影響。

但在「讓AI更懂人」這件事上,小紅書似乎有更大的動力去投入研發。

畢竟小紅書目前的月活已超過3.5億,每天都有用戶生成海量的圖文內容,如何更好地理解這些內容,進行更精準的個性化推薦,大模型能起到不小的作用。

同時,未來AI如何參與到社區的交互中,會是個值得長期探索的問題。

小紅書在技術自研上的決心也較以往更大。

除了去年自建云之外,最近有個小道消息很多人忽略了——小紅書8月中旬將切換在線辦公軟件,從企業微信全面遷移到自研的redcity。

當時一些同學認為,「自研IM」是獨角獸到一線大廠的必經之路,這是一種明確的戰略轉向。

所以,小紅書下場自研大模型也是非常說得通了,甚至可以說是一種必然。

小紅書追求的多元智能

不論是兩個月前開源的dots.llm1,上周開源的dots.ocr,還是最新發布的dots.vlm1,可以看到小紅書人文智能實驗室已經打定主意自己搞自己的大模型了。

dots模型家族也在不斷壯大。

另一個值得注意的點就是,此次dots.vlm1是基于DeepSeek V3的,而不是他們自己的dots.llm1。

可以推測,這在小紅書內部立項時,應該是同時并行開始的,可能vlm訓練更復雜,所以稍慢一些。

但說明小紅書一開始就想到要做自研的多模態大模型了。未來不排除dots的多模態模型會基于dots的文本模型訓練。

也許小紅書會把這次VLM當作「理解底座」,先把「看懂用戶、看懂內容」做到極致,再漸進式開發后續的圖生圖、視頻生成等創作能力。

也許這些模型能力未來會和小紅書的應用產品做更好的結合,來自證「模應一體」的預言。

今年年初,小紅書hi lab就開始招募「AI人文訓練師」團隊,幫助AI更好地進行后訓練。

「AI人文訓練師」的團隊人員背景非常多元,包括哲學、文學、政治學、人類學、歷史、電影藝術等。這些「文科專業」某種程度上也折射出小紅書對于多模態的一種深度理解。